۱٫ معرفی

استفاده از آخرین فن آوری در شکل گیری تجربه آموزشی در محیط آموزشی که به سرعت در حال تغییر است، اهمیت فزاینده ای داشته است. [۱,۲]. معلمان باید بیشتر از همیشه تلاش کنند تا دانش آموزان خود را هنگام یادگیری آنلاین علاقه مند نگه دارند و به آنها توجه کنند. استفاده از فناوری فعلی برای بهبود یادگیری آنلاین و حفظ مشارکت دانش آموزان در محیط آموزشی در حال تغییر امروز بسیار مهم است. با توجه به موضوع چالش برانگیز نظارت و افزایش مشارکت دانش آموزان در محیط های یادگیری آنلاین، این مطالعه با هدف طبقه بندی فعالیت های دانش آموزان بر اساس موقعیت سر در طول امتحانات انجام می شود. هدف این کار پیشنهادی کمک به حوزه آموزشی با استفاده از فناوری مدرن برای طبقهبندی فعالیتهای دانشآموزان بر اساس موقعیتهای متفاوت سر است. فرصتها و چالشها بسیار زیاد است، زیرا مدارس بیشتر و بیشتر از تحول دیجیتال استقبال میکنند، به این معنی که کلاسهای معمولی جای خود را به یادگیری آنلاین میدهند. یک مانع مهم اندازه گیری و بهبود مشارکت دانش آموزان است که برای نتایج موفقیت آمیز یادگیری ضروری است [۳,۴]. محیط های آنلاین ممکن است برای استفاده از تکنیک های آزمایش شده و واقعی برای اندازه گیری تمرکز، مانند مشاهده مستقیم، مساعدتر باشند.

یادگیری فدرال (FL) به کاربران متعدد اجازه می دهد تا با هم کار کنند، در حالی که از نظر فیزیکی در مکان های مختلف قرار دارند، با به اشتراک گذاری داده ها برای آموزش یک مدل یادگیری عمیق (DL) به طور تدریجی بهتر. [۵,۶]. هر مشتری یک مدل از پیش آموزش دیده را از یک مرکز داده ابری دانلود می کند. دادههای محرمانه برای آموزش مدل استفاده میشود که میتوان متعاقباً خلاصه و رمزگذاری کرد [۷,۸]. به منظور گنجاندن بهروزرسانیهای مدل در مدل متمرکز، این بهروزرسانیها به ابر منتقل، رمزگشایی و میانگینگیری میشوند. تا زمانی که مدل به طور کامل آموزش داده نشود، آموزش مشارکتی به تکرار پس از تکرار ادامه میدهد [۹,۱۰].

فدراسیون یک سرور مرکزی و مشتریان فردی وظایف FL را حل می کند. برخلاف DL کلاسیک، FL دارای مدل های جهانی و فردی است [۱۱,۱۲]. در شبکه های فدرال، داده های اعتبارسنجی بین دستگاه ها توزیع می شود و دسترسی به مجموعه داده کامل را محدود می کند. در عوض، یک سرور مرکزی ممکن است به تعداد محدودی دستگاه در هر چرخه ارتباطی برای آموزش محلی و اعتبارسنجی دسترسی داشته باشد. تعداد دورهای ارتباطی معیار پیچیدگی سنتی در FL است، بنابراین محاسبه معیارهای اعتبارسنجی به طور قابل توجهی هزینه را افزایش می دهد. از آنجایی که دو بخش به یک اندازه ضروری این روش را انجام می دهند، بهتر است هر دو را به طور همزمان انجام دهید. FL برای عملکرد خوب به هایپرپارامترهای بیشتری نسبت به مدل DL نیاز دارد [۱۳,۱۴]. فراپارامترهای FL به طور قابل توجهی بر سربار آموزشی در مورد محاسبات و بار انتقال تأثیر می گذارد [۱۵,۱۶]. FL یک پارادایم ML توزیع شده است که در آن چندین مشتری مدل ها را بدون متمرکز کردن داده ها آموزش می دهند. در FL، انتخاب هایپرپارامتر بر بهینه سازی محلی مشتری و عملیات تجمیع سرور تأثیر می گذارد، که شبیه به ML معمولی است. انتخاب دستی فراپارامترهای FL برای تمرینکنندگان سخت است، زیرا برنامههای کاربردی مختلف اولویتهای آموزشی متفاوتی دارند. [۱۷,۱۸,۱۹].

کار پیشنهادی وضعیت سر دانشآموزان را تجزیه و تحلیل و طبقهبندی میکند تا توجه آنها را در طول امتحانات آنلاین در محیط FL ارزیابی کند. چندین حوزه، از جمله نظارت بر امنیت و تعامل انسان و رایانه، شروع به برجسته کردن تجزیه و تحلیل موقعیت سر کرده اند. با این حال، پتانسیل آن در کلاس درس هنوز به طور کامل بررسی نشده است، به ویژه در اندازه گیری توجه دانش آموزان در طول فعالیت آنلاین. این مطالعه با تمرکز بر پنج حالت سر، دانش مفصلی از مشارکت دانشآموزان در طول جلسات یادگیری مجازی ارائه میدهد: صورت جلو، صورت پایین، صورت راست، صورت بالا و صورت چپ.

بزرگترین مشکل مدل DL از پیش آموزش دیده (ResNet50) این است که تنظیمات معماری و هایپرپارامتر آن مختص کار است و به مجموعه داده بستگی دارد. [۲۰,۲۱,۲۲]. شناسایی و یافتن بهترین هایپرپارامترهای ممکن در فضای جستجو، یک مرحله ضروری پیش از آموزش مدل ResNet50 است. برای شناسایی بهترین هایپرپارامترهای ممکن در مدل ResNet50، یک روش بهینهسازی الهامگرفته از زیستی مورد نیاز است، بنابراین با تنظیم دقیق بهترین هایپرپارامترهای ممکن شناساییشده، به بالاترین دقت دست مییابد.

استقرار رویکردهای فراابتکاری برای حل مسائل مختلف به طور تصاعدی رشد کرده است [۲۳,۲۴]. این روش ها از روش های مرسوم برای حل مسائل بهینه سازی با درجه بسیار بالایی از پیچیدگی بهتر عمل می کنند. علاوه بر این، آنها از نظر سرعت و سهولت اجرا از روش های بهینه سازی استاندارد بهتر عمل می کنند.

دسته های مختلف رویکردهای بهینه سازی الهام گرفته از زیستی از الگوریتم های تکاملی (EAs)، هوش ازدحام (SI) و غیره الهام می گیرند. اولین نوع الگوریتم به نام EA، انگیزه خود را از تلاش برای مدل سازی فرآیندهای ژنتیکی اساسی مانند انتخاب، متقاطع، و جهش نوع دوم الگوریتم، تکنیک Swarm Intelligence (SI)، سناریویی مشابه نحوه جستجوی غذا ازدحام در طبیعت وحشی انجام می دهد. بهینه ساز چند آیه (MVO)، بهینه سازی ازدحام ذرات (PSO)، الگوریتم ازدحام سالپ (SSA) و الگوریتم بهینه سازی نهنگ (WOA) پرکاربردترین تکنیک ها در بین این الگوریتم ها هستند. [۲۵,۲۶].

مشارکت های کلیدی این مقاله به شرح زیر است:

- (۱)

-

طراحی روشهای بهینهسازی جدید ترکیبی الهامگرفته از زیستی برای تنظیم دقیق فراپارامترهای مدل ResNet50: PSOGA (بهینهسازی ازدحام ذرات (PSO) با الگوریتم ژنتیک (GA)) و PSOEGA (PSO با Elitist GA).

- (۲)

-

شناسایی فعالیت دانشآموزان با طبقهبندی ژستهای سر در طول امتحانات آنلاین با استفاده از FL با مدل ResNet50 بهینه و تکنیکهای ترکیبی الهامگرفته از زیستی.

بقیه این مقاله به شرح زیر سازماندهی شده است. بخش ۲ کارهای کلیدی مرتبط موجود را توضیح می دهد. بخش ۳ روش پیشنهادی را تشریح می کند. بخش ۴ نتایج و تجزیه و تحلیل را مورد بحث قرار می دهد. بخش ۵ کار را با جهت گیری های آینده به پایان می رساند.

۲٫ آثار مرتبط

همه گیری COVID-19 به طور قابل توجهی به افزایش جهانی اخیر در محبوبیت آموزش آنلاین کمک کرده است [۲۷]. اتم و همکاران [۲۸] مدلی را توسعه داد که قادر به شناسایی فعالیت های تقلب در طول امتحانات آنلاین با استفاده از وب کم، دوربین پوشیدنی و میکروفون است. نتایج به این نتیجه رسیدند که بررسی خودکار برای برگزاری امتحانات در یک محیط آنلاین کافی و دقیق است. گانیدی و همکاران [۲۹] مدلی را با استفاده از تکنیک های یادگیری عمیق برای تشخیص چهره در امتحانات آنلاین پیشنهاد کرد. با این حال، آنها در شرایط نوری ضعیف و زمانی که وضعیت های خاص تشخیص داده نمی شوند، غیرفعال می شوند. اشوین و همکاران [۳۰] یک الگوریتم کاوشگر با استفاده از یادگیری انتقالی برای یادگیری عمیق ایجاد کرد، بنابراین ناهنجاریها را شناسایی کرد: جعل هویت، استفاده از اشیاء/ابزارهای تقلبی برای تقلب، و الگوهای نگاه غیرعادی دانشآموزان. سونگ و همکاران [۳۱] مدل YOLOv3 را برای شناسایی صورت تک گوسفند در نظر گرفت. نتایج تجربی نشان داد که مدل YOLOv3 لبه تشخیص بالاتری نسبت به YOLOv1 و YOLOv2 دارد. پراتیش و همکاران [۳۲] ویژگی هایی از جمله استخراج نقطه و تشخیص زاویه انحراف برای کمک به مربیان در نظارت بر دانش آموزان در طول امتحانات آنلاین در نظر گرفته شده است. حسن و همکاران [۳۳] الگوریتم هایی را برای استخراج ویژگی ها از سیگنال های حسگر و انجام طبقه بندی فعالیت های انسانی با استفاده از مدل های یادگیری ماشین توسعه داده است. حسین و همکاران [۳۴] سیستمهای یادگیری الکترونیکی پیشنهادی شامل یادگیری عمیق ترکیبی برای شناسایی سبک یادگیری خودکار مدل آنها در تشخیص سبک های یادگیری از کارهای موجود بهتر عمل می کند، بنابراین کیفیت ارائه محتوای سفارشی شده را افزایش می دهد.

FL یک تکنیک ML غیرمتمرکز و مشارکتی است که الگوریتمهای آموزشی را در دستگاههای لبه امکانپذیر میکند. [۳۵,۳۶]. در تکنیکهای سنتی ML، دادههای دستگاههای محلی برای محاسبه با سرور به اشتراک گذاشته میشوند [۳۷,۳۸]. با این حال، FL زمانی قابل استفاده است که دستگاه ها نمی خواهند داده ها را با سرور به اشتراک بگذارند. راث و همکاران [۳۹] یک رویکرد یادگیری فدرال برای طبقهبندی تصویربرداری پزشکی پیشنهاد کرد و بر اساس نتایج تجربی، یادگیری فدرال در سناریوهای دنیای واقعی میتواند دقت مدل محلی را بهبود بخشد. مک ماهان و همکاران [۴۰] نشان داد که FedAvg میتواند مدلهای با کیفیت بالا را تنها با دورهای ارتباطی محدود در معماریهای مدلهای مختلف آموزش دهد. زو و همکاران [۴۱] چارچوب یادگیری تقویت عمیق فدرال را پیشنهاد کرد که برای رسیدگی به مسائل مربوط به فضاهای ویژگی کوچک در ایالت ها و داده های آموزشی محدود طراحی شده است. علاوه بر این، روشهای یادگیری انتقالی در یادگیری تقویتی عمیق برای بهبود عملکرد مدل پیشنهاد شد. در یادگیری فدرال، گرههای کار، کاربران شرکتکنندهای هستند که دادههای محلی خود را دارند و مستقل از سرور کار میکنند. مزیت کلیدی یادگیری فدرال توانایی آن در حفظ حریم خصوصی و امنیت داده ها است [۴۲]. رای و همکاران [۴۳] یک رویکرد FL را ارائه کرد که به انتخاب مشتری برای داده های متعادل و نامتعادل پرداخت و دریافت که توزیع داده ها به طور مساوی بین مشتریان می تواند عملکرد آن را افزایش دهد.

جدول ۱ نتایج بررسی ادبیات را نشان می دهد. مشاهده می شود که معماری خاص کار و انتخاب هایپرپارامتر به مجموعه داده بستگی دارد، که مسئله اصلی مدل ResNet50 است. انتخاب هایپرپارامترهای صحیح قبل از آموزش ResNet50 یک کار بسیار مهم است. یافتن فراپارامترهای بهینه نیاز به فضای جستجوی بهینه دارد. روشهای بهینهسازی الهامگرفته از زیستی به کار رفته در مدل ResNet50 برای آموزش و طبقهبندی رفتار دانشآموزان در محیط امتحان آنلاین استفاده میشوند. بنابراین، در این کار، روشهای بهینهسازی الهامگرفته از زیستی را برای تنظیم دقیق فراپارامترهای مدل ResNet50 به منظور دستیابی به حداکثر دقت ضروری در نظر میگیریم.

۳٫ روش پیشنهادی

۳٫۱٫ مدل یادگیری عمیق از پیش آموزش دیده (ResNet50)

در کار پیشنهادی با استفاده از چارچوب FL، مدلهای یادگیری در دستگاههای مشتری محلی با استفاده از مدل ResNet50 از پیش آموزشدیده برای آموزش دادهها آموزش داده میشوند. برای تنظیم دقیق هایپرپارامترها در مدل ResNet50، روشهای بهینهسازی PSOGA و PSOEGA را همانطور که در شکل ۱ نشان داده شده است، پیشنهاد کردیم. ResNet50 دو نوع نقشهبرداری دارد: نگاشت هویت، که به خط منحنی اشاره دارد، و نگاشت باقیمانده، که به هر چیز دیگری اشاره دارد. . از خط منحنی، منجر به خروجی نهایی می شود . نقشه برداری باقی مانده به تفاوت دو نقطه اشاره دارد: y و ایکس. در مقابل، نگاشت هویت، ایکسبه خود اشاره دارد که توسط ایکس در فرمول ResNet-50 وظایف طبقه بندی را پس از یک عملیات کانولوشن، سه بلوک باقیمانده و یک عملیات اتصال کامل در شبکه ResNet50 انجام می دهد که شامل ۵۰ لایه Conv2D، و به دنبال آن لایه کاملا متصل (FC) و آخرین لایه (لایه خروجی) شبکه ResNet50 دو لایه اول کانولوشن و ادغام را به عنوان مهندسی ویژگی، تقویت موضعی و استخراج ویژگی و لایه سوم و چهارم لایه FC را به عنوان وزن دهی ویژگی در نظر بگیرید. دادههای مسطح شده که به بردارهای ستونی تبدیل میشوند، سپس به شبکه عصبی پیشخور داده میشوند تا تصویر را برای پرسپترون چند لایه آماده کند. این داده های مسطح در هر تکرار آموزشی استفاده می شود. توانایی مدل برای تمایز اجزای تصویر اولیه و سطح پایین و طبقه بندی آنها توسط تابع فعال سازی ReLU، همانطور که در شکل ۲ نشان داده شده است، افزایش می یابد.

۳٫۲٫ استقرار مدل ResNet50 یادگیری عمیق در چارچوب یادگیری فدرال

FL همکاری بین چندین طرف را برای توسعه مدل بدون به اشتراک گذاشتن صریح داده های آنها تسهیل می کند. این روش شامل آموزش مدل در یک شبکه غیرمتمرکز است، جایی که داده ها با دستگاه های مشتری یا سرورهای محلی در مکان های مختلف باقی می مانند. در کار پیشنهادی در محیط FL، مدل بر روی یک سرور مرکزی مقداردهی اولیه میشود و سپس به دستگاههای مشتری که دادهها را تولید میکنند، توزیع میشود. هر دستگاه کلاینت مدل را با استفاده از داده های موجود محلی آموزش می دهد و بنابراین پارامترهای مدل به روز شده را به سرور مرکزی برمی گرداند. از این رو، در رویکرد FL پیشنهادی ما با دستگاههای مشتری محلی، مدل ResNet50 را برای طبقهبندی وضعیتهای سر در طول امتحانات آنلاین ادغام میکنیم. این کار پیشنهادی عمدتاً به تنظیم دقیق بهترین هایپرپارامترهای ممکن در دستگاه های مشتری محلی برای دقت بهتر کمک می کند. بنابراین، ما دو روش ترکیبی الهام گرفته از زیستی، یعنی بهینهسازی ازدحام ذرات با الگوریتم ژنتیک (PSOGA) و بهینهسازی ازدحام ذرات با الگوریتم ژنتیک نخبهگرا (PSOEGA) را برای تنظیم دقیق فراپارامترهای مدل ResNet50 همانطور که در شکل ۳ نشان داده شده است، پیشنهاد میکنیم.

سرور مرکزی پارامترهای به روز شده دریافتی از هر دستگاه را برای به روز رسانی مدل جهانی جمع آوری می کند. این فرآیند به روز رسانی تکراری است و تا زمانی که مدل به عملکرد و دقت رضایت بخشی دست یابد، ادامه خواهد داشت.

آموزش سمت مشتری مدل FL در اینجا توضیح داده شده است. کلاس LocalUpdate شبکه عصبی را روی مجموعه داده های محلی برای یک کلاینت مشخص آموزش می دهد. آرگومانها، مجموعه دادهها و شاخصهای نمونههایی که باید برای آموزش استفاده شوند را به عنوان ورودی میگیرد. کلاس با یک تابع از دست دادن، لیستی از مشتریان انتخاب شده و یک بارگذار داده که مجموعه داده های محلی را بارگذاری می کند، مقداردهی اولیه می شود. روش آموزش کلاس LocalUpdate یک مدل ResNet50 را به عنوان ورودی می گیرد و آن را با استفاده از گرادیان نزولی تصادفی بر روی مجموعه داده های محلی آموزش می دهد. بهینه ساز و تابع تلفات را اولیه می کند و مدل را برای تعداد ثابتی از دوره ها آموزش می دهد. در طول هر دور FL، بهروزرسانیهای محلی توسط دستگاههای کلاینت با استفاده از مجموعه دادههای محلی خود با کمک کلاس LocalUpdate انجام میشود. مشتریان محلی وزن های مدل به روز شده خود را پس از آموزش به سرور ارسال می کنند تا سرور بتواند وزن ها را در تمام مشتریان محلی جمع آوری کند و مدل جهانی را به روز کند. این فرآیند بهروزرسانی برای چندین دور تکرار میشود تا زمانی که همگرا شود.

این بخش تجمیع سمت مشتری مدل FL را توضیح می دهد. در مقابل، در تجمیع سمت سرور، سرور پارامترهای به روز شده دریافتی از هر کلاینت را جمع آوری و تجمیع می کند و یک مدل جهانی تولید می کند. پس از اتمام آموزش توسط کلاینت های محلی، پارامترهای به روز شده کلاینت ها برای تجمیع به سرور ارسال می شود. سیستم کاوش آنلاین پیشنهادی ما با استفاده از مدل FL، فرآیند تجمیع را در سرور با استفاده از الگوریتم میانگینگیری فدرال انجام میدهد. سرور می تواند آموزش را شروع کند تا هر دستگاه مشتری محلی بتواند یک به روز رسانی اولیه جهانی را دریافت کند. سپس هر کلاینت می تواند این مدل جهانی را به صورت محلی با استفاده از داده های موجود آموزش دهد و پارامترهای به روز شده کلاینت ها به سرور ارسال می شود و یک مدل جهانی جدید ایجاد می کند. این فرآیند به روز رسانی تا زمانی که عملکردهای دقت و از دست دادن همگرا شوند تکرار می شود.

۳٫۳٫ تنظیم فراپارامتر مدل ResNet50 در چارچوب یادگیری فدرال

تکنیک تنظیم هایپرپارامتر شامل انتخاب بهترین هایپرپارامترها برای به حداکثر رساندن عملکرد مدل ResNet50 است. فرآیند بهینه سازی اغلب شامل بررسی فضای از پیش تعیین شده یا محدوده مقادیر بالقوه برای هر هایپرپارامتر است. بنابراین، در این کار، روشهای GA، PSO، PSOGA و PSOEGA را برای تنظیم دقیق فراپارامترهای مدل ResNet50 در نظر گرفتیم.

۳٫۴٫ بهینه سازی ازدحام ذرات

بهینه سازی ازدحام ذرات (PSO) از بردارهای اعداد واقعی m بعدی برای نشان دادن هر ذره در جمعیت استفاده می کند. روش PSO با در نظر گرفتن هر ازدحام ذرات به عنوان یک راه حل بالقوه به دست آمده در یک فضای جستجوی محدود تکامل می یابد. [۴۸].

PSO به طور تصادفی یک جمعیت ذره را مقداردهی اولیه می کند. پس از مقداردهی اولیه جمعیت PSO، یک رویه تکاملی برای چندین نسل اجرا می شود [۴۹]. هر ذره (فرد) بر اساس موقعیت و سرعت بهترین تجربه قبلی خود (بهترین) و بهترین تجربه قبلی ذرات ازدحام (بهترین) جهت یافتن راه حل بهینه را تغییر می دهد. مکان فعلی و امتیاز عملکرد هر ذره پس از مقداردهی اولیه موقعیت و سرعت آن محاسبه می شود. تکرار زیر شامل تغییر موقعیت جدید ذره پس از محاسبه سرعت آن با استفاده از موقعیت محلی فعلی و موقعیت جهانی آن است. معادله (۱) سرعت به روز شده را محاسبه می کند برای ذرات من در تکرار در چارچوب بهینه سازی ازدحام ذرات (PSO). این سرعت به صورت مجموع سه جمله محاسبه می شود: جمله اینرسی w ضرب در سرعت قبلی اصطلاح شناختی ضرب در یک عامل تصادفی نشان دهنده یادگیری شناختی و تفاوت بین موقعیت فعلی ذره است و بهترین موقعیت شخصی او . علاوه بر این، اصطلاح اجتماعی را نیز شامل می شود ضرب در یک عامل تصادفی دیگر نشان دهنده یادگیری اجتماعی و تفاوت بین بهترین موقعیت جهانی است و موقعیت فعلی ذره .

معادله (۲) موقعیت ذره را به روز می کند

از موقعیت فعلی خود در تکرار

ک به موقعیت جدید خود در تکرار

با ترکیب سرعت به روز شده آن

.

۳٫۵٫ الگوریتم ژنتیک

انتخاب طبیعی و تکامل بر یک تکنیک بهینهسازی فراابتکاری به نام الگوریتم ژنتیک (GA) تأثیر میگذارد. GA روی جمعیتی از راه حل های کاندید در زمینه تنظیم فراپارامتر عمل می کند، جایی که هر راه حل کاندید مربوط به مجموعه ای از فراپارامترها برای یک مدل یادگیری ماشین است. GA مجموعه ایدهآل ابرپارامترها را با اعمال عملیات ژنتیکی روی جمعیت، از جمله انتخاب، متقاطع و جهش جستجو میکند. Initialization نامزدهای فضای جستجو را به طور تصادفی انتخاب می کند [۵۰]. در این تحقیق، اندازه فضای جستجو را به عنوان ورودی از مجموعه هایپرپارامتر تعریف می کنیم. ما همچنین از یک توزیع یکنواخت برای اطمینان از تصادفی بودن نامزدهای فضای جستجو استفاده می کنیم. هر هایپرپارامتر دارای یک محدوده تعریف شده است که در آن ژن می تواند مقادیری را در نظر بگیرد و فضای جستجوی GA را محدود کند. [۵۱]. در زمان اولیه سازی جمعیت، هایپرپارامترها تنظیم می شوند و یک مقدار تصادفی در بازه از پیش تعریف شده برای رمزگذاری کروموزوم انتخاب می شود. ما ترک تحصیل، نرخ یادگیری و ضریب حرکت را برای رمزگذاری کروموزومی در یک آرایه شامل میکنیم. هر کروموزوم شامل سه ژن است که هر کدام یک مقدار دقیق برای فراپارامتر خود را رمزگذاری می کنند.

تناسب اندام انتخاب می شود، با مناسب ترین کروموزوم ها که در تولید مثل شرکت می کنند. کروموزوم های نسل کنونی با بالاترین سطح تناسب اندام به احتمال زیاد جمعیت آینده را در این اپراتور ایجاد می کنند. این مطالعه از رتبه بندی خطی و انتخاب مسابقات استفاده کرد.

رتبه بندی خطی افراد را بر اساس تناسب اندام طبقه بندی می کند، با احتمال انتخاب منحصراً بر اساس تناسب اندام. بدترین فرد رتبه ۱ را دریافت می کند و دومین بدترین درجه ۲ را دریافت می کند. این روند تا زمانی ادامه می یابد که فرد برتر رتبه N را بدست آورد که منعکس کننده تعداد کروموزومی جمعیت است. هر فردی یک احتمال دارد پ انتخاب شدن از جمعیت N نفر بر اساس رتبه بندی آنها که در رابطه (۳) تعریف شده است. در اینجا، p نشاندهنده احتمال یا امتیاز نرمال شده است که به یک رتبه خاص اختصاص داده شده است و رتبه، موقعیت رتبه یک فرد یا آیتم است که معمولاً از ۱ برای بالاترین رتبه شروع میشود و N تعداد کل افراد است.

الگوریتم ژنتیک الیتیست

الگوریتم ژنتیک نخبهگرا (EGA) یک مکانیسم نخبهگرایی است که تضمین میکند بهترین راهحلها (افراد) از یک نسل بدون هیچ تغییری به نسل بعدی منتقل میشوند. این رویکرد به دلیل ماهیت تصادفی عملیات ژنتیکی مانند متقاطع و جهش، از دست دادن بهترین راه حل های یافت شده جلوگیری می کند. EGA یک استراتژی است که در تنظیم هایپرپارامتر برای افزایش کارایی بهینه سازی با حفظ بهترین راه حل ها در بین نسل ها استفاده می شود. در این رویکرد، یک الگوریتم ژنتیک برای بهینهسازی فراپارامترها استفاده میشود، که در آن جمعیتی از مجموعههای ابرپارامترهای بالقوه در طول نسلهای متعدد تکامل مییابند. عملکرد هر مجموعه با استفاده از دقت به عنوان تابع تناسب ارزیابی می شود. ست های با عملکرد برتر، که از طریق امتیازات تناسب اندام آنها شناسایی می شوند، مستقیماً برای نسل بعدی کپی می شوند تا ویژگی های با کیفیت خود را حفظ کنند. بقیه جمعیت از طریق فرآیندهای انتخاب، متقاطع و جهش تولید میشوند که تنوع را معرفی میکند و امکان اکتشاف را فراهم میکند. این استراتژی تضمین میکند که بهترین پیکربندیهای فراپارامتر از بین نمیروند، همگرایی را به سمت یک راهحل بهینه تسریع میکند و در عین حال تنوع در جمعیت را حفظ میکند تا از همگرایی زودرس جلوگیری شود.

۳٫۶٫ بهینه سازی ازدحام ذرات با الگوریتم ژنتیک (PSOGA)

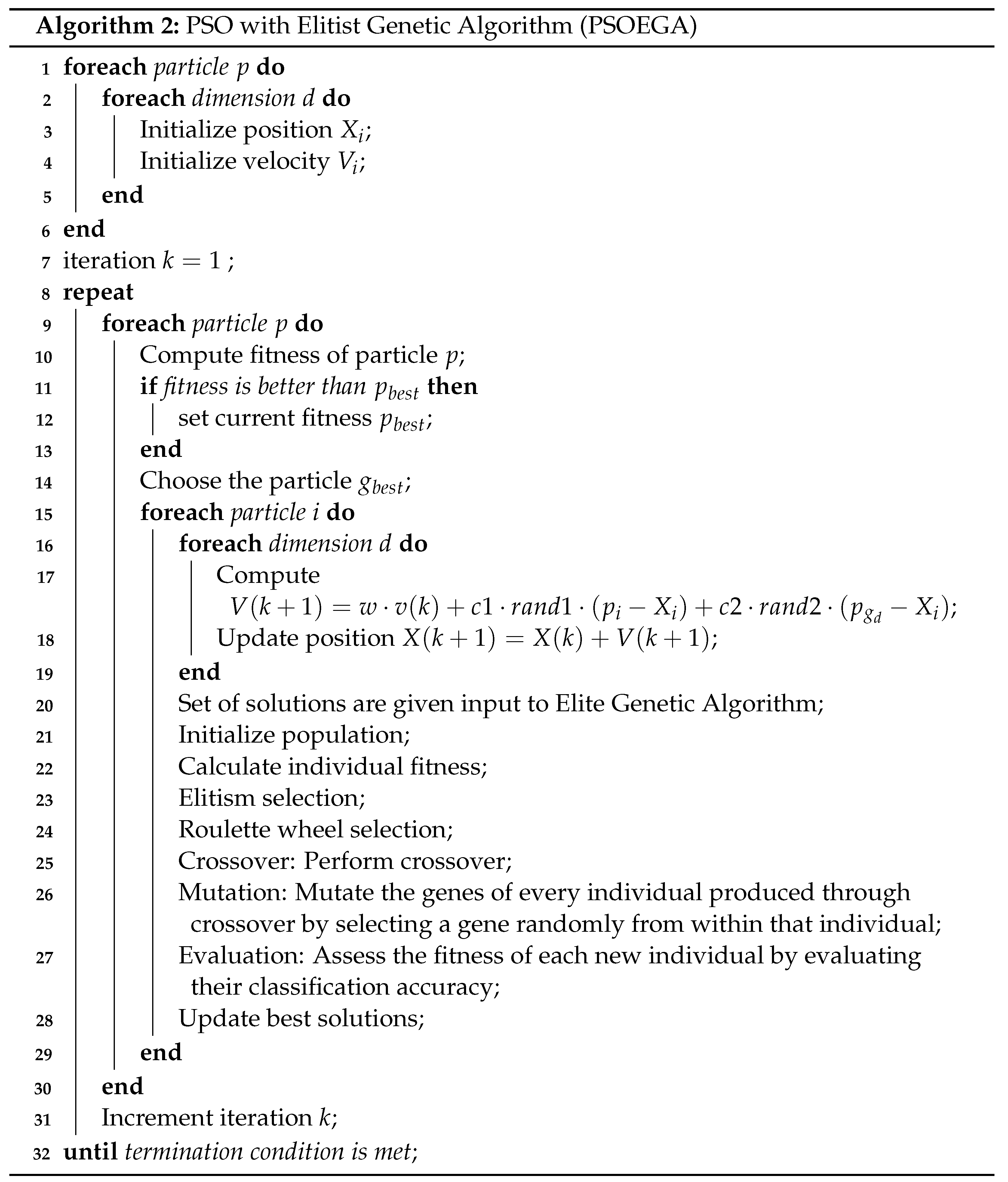

در زمینه تنظیم فراپارامتر، ما این دو الگوریتم را برای استفاده از هر دو مزیت و به دست آوردن نتایج بهینه جهانی با همگرایی سریع ترکیب میکنیم. ابتدا، ازدحام جمعیت را مقداردهی اولیه می کنیم. PSO هر ذره را به عنوان یک راه حل بالقوه (مجموعه ای از فراپارامترها) در نظر می گیرد و همان مراحلی را که قبلاً برای PSO بحث شد دنبال می کند و حرکت ذرات را در فضای جستجو تقلید می کند تا پیکربندی فراپارامتر بهینه را پیدا کند. برای یافتن بهترین موقعیت های محلی و جهانی، مولفه های شناختی و اجتماعی محاسبه می شود. سرعت با استفاده از وزن اینرسی، مؤلفه شناختی و مؤلفه اجتماعی به روز می شود. موقعیت با اضافه کردن سرعت به موقعیت فعلی به روز می شود و در نهایت شرایط پایان را بررسی می کند. اگر شرط نادرست باشد، از رویکرد GA پیروی می کند و والدین را به طور تصادفی از جمعیت انتخاب می کند. پس از آن، جهش برای تغییر ماده ژنتیکی (مقادیر فراپارامتر) افراد فرزندان انجام می شود. سپس والدین به همراه فرزندان به جمعیت جدید اضافه می شوند. ازدحام با یک جمعیت جدید به روز می شود، و این روند تا زمانی که شرایط خاتمه ایجاد شود، تکرار می شود. بدترین حالت پیچیدگی زمانی PSOGA پیشنهادی است ، جایی که G تعداد نسلها، N تعداد ذرات PSO یا افراد در GA، d تعداد ابعاد (هیپرپارامترها) و T زمان محاسبه تابع تناسب است. الگوریتم ۱ اصل کار PSOGA را نشان می دهد.

۳٫۷٫ بهینه سازی ازدحام ذرات با الگوریتم ژنتیک الیتیست (PSOEGA)

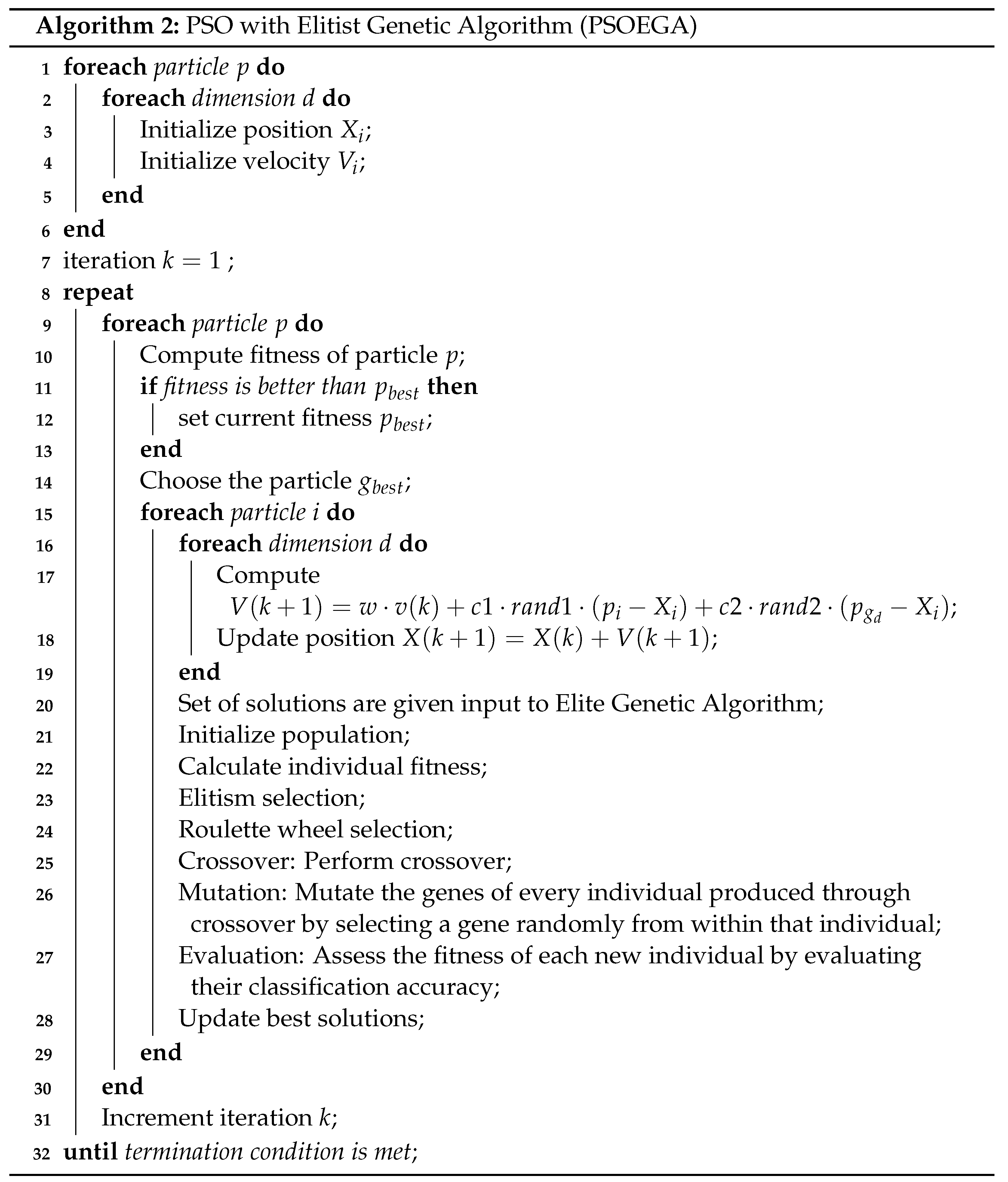

PSOEGA از یک روش ژنتیکی برای پالایش بیشتر جمعیت ذرات استفاده می کند. فقط مجموعهای از ذرات، معمولاً بهترین عملکردها، برای دستکاریهای ژنتیکی انتخاب میشوند [۵۲]. متقاطع برای وادار کردن افراد نخبه مانند نوترکیب های ژنتیکی استفاده می شود. مجموعههای فراپارامتر بین دو ذره بالا مبادله میشوند تا راهحلهای جدیدی ایجاد کنند که ویژگیهای هر دو والدین را به خود بگیرد. وقتی افراد نخبه منتخب تحت جهش قرار می گیرند، تنظیمات فراپارامتر آنها دستخوش تغییرات تصادفی می شود. بنابراین، به جای گیر کردن در بهینه محلی، فضای راه حل را می توان به طور کامل کاوش کرد. به دلیل فرآیندهایی مانند جهش و متقاطع، نسل های جدید جایگزین برخی از اعضای جمعیت اصلی خواهند شد. بنابراین، هر تکرار مجموعه جدیدی از مقادیر فراپارامتر خواهد داشت. مدل ResNet50 برای یافتن تناسب افراد تازه تولید شده آموزش دیده است. این مرحله تعیین می کند که آیا تغییرات ایجاد شده از طریق عملیات ژنتیکی عملکرد مدل را بهبود می بخشد یا بدتر می کند.

PSO و EGA برای تنظیم دقیق فراپارامترهای مدل ResNet50 همکاری می کنند. همانطور که PSO جستجو را در فضای راه حل هدایت می کند، EGA از عملیات ژنتیکی برای تنظیم دقیق راه حل های با بهترین عملکرد استفاده می کند. اولین گام در بهینه سازی با جمعیتی از ذرات با مجموعه هایپرپارامتر ResNet50 مختلف شروع می شود. PSO بهطور مداوم مکانها و سرعتهای ذرات را بر اساس تابع تناسب زمانی که یک نیاز توقف برآورده میشود، بهروزرسانی میکند. ذرات با بهترین عملکرد، همانطور که توسط PSO تعیین می شود، به عنوان افراد نخبه برای استفاده در الگوریتم ژنتیک انتخاب می شوند. افراد نخبه تحت عملیات ژنتیکی مانند جهش و متقاطع قرار می گیرند تا مجموعه جدیدی از فراپارامترها تولید کنند. با آموزش مدل ResNet50 میتوانیم تناسب راهحلهای جدید تولید شده را ارزیابی کنیم. فرآیند ترکیبی PSO و EGA پس از تعداد معینی از تکرارها یا زمانی که یک نیاز همگرایی برآورده می شود متوقف می شود. بدترین پیچیدگی زمانی PSOEGA پیشنهادی مانند PSOGA است. جزئیات PSOEGA در الگوریتم ۲ نشان داده شده است.

۴٫ تجزیه و تحلیل نتایج

مجموعه داده مورد استفاده برای این پروژه شامل ژستهای سر ۲۵۰ نفر در دسترس عموم از یک مقاله تحقیقاتی توسط Gourier و همکاران است. [۵۳]. ما همچنین تصاویری را از وب اضافه کردیم تا اندازه مجموعه داده را افزایش دهیم و تصاویر مختلفی با پسزمینهها، قومیتها و جنسیتهای مختلف را شامل شود. مجموعه داده شامل نمونه هایی از افراد با رنگ پوست متفاوت و با یا بدون عینک مطالعه است. ما حالت های سر را به صورت چپ، راست، بالا، پایین و جلو فیلتر کردیم. در مجموع ۱۷۸۶ تصویر برای انجام این آزمایش در نظر گرفته شد که شامل پنج برچسب بود: صورت جلو، صورت پایین، صورت راست، صورت بالا و صورت چپ. شکل ۴ مجموعه داده نمونه مورد استفاده برای مطالعه تجربی ما را نشان می دهد.

ما سه مشتری، اندازه دسته ای ۳۲ و نرخ یادگیری آموزشی ۰٫۰۰۱ را برای انجام آزمایش خود در نظر می گیریم. تصاویر ورودی به اندازه ۲۲۴ × ۲۲۴ پیکسل کوچک شده اند. این مدل از نزول گرادیان تصادفی (SGD) به عنوان بهینه ساز استفاده می کند. مجموعه داده به سه قسمت تقسیم شده است و ما سه مشتری را برای این آزمایش در نظر می گیریم. ما مدل را با ۵۹۶ تصویر برای هر مشتری آموزش می دهیم. مجموعه داده در هر مشتری به مجموعه های آموزشی و آزمایشی با نسبت ۸۰:۲۰ تقسیم می شود. جدول ۲ ابزارها و فناوری های مورد استفاده برای کار ما را نشان می دهد.

۴٫۱٫ پارامترهای تنظیم فراپارامتر

پارامترهای در نظر گرفته شده برای تنظیم هایپرپارامتر، نرخ یادگیری و دوره محلی است. جدول ۳ فهرستی از پارامترهای مورد استفاده در آزمایش را نشان می دهد.

۴٫۲٫ نتایج مدل های یادگیری عمیق متمرکز

جدول ۴ نتایج اجرای مدل متمرکز ResNet50 را برای ده دوره با نرخ یادگیری ۰٫۰۱ نشان می دهد.

۴٫۳٫ نتایج مدل های یادگیری عمیق غیرمتمرکز

ما مدل ResNet50 غیرمتمرکز را بر روی مجموعه داده برای ده دوره با نرخ یادگیری ۰٫۰۰۱ اجرا کردیم. جدول ۵ نتایج ارزیابی مدل های FL را بر روی مجموعه داده نشان می دهد. با مقایسه این نتیجه با نتیجه متمرکز، مشاهده میکنیم که عملکرد مدلهای DL غیرمتمرکز زمانی که مدلها را با تنظیمات مشابه با رویکرد متمرکز اجرا میکنیم، ۳٫۷ درصد کاهش مییابد. این ممکن است نتیجه سربار در ارتباطات یا تأخیر اضافی باشد.

۴٫۴٫ نتایج الگوریتم ژنتیک

در این رویکرد، مدل ResNet-50 را بر روی الگوریتم ژنتیک اجرا می کنیم، همانطور که در بخش ۳٫۵ بحث شد. ما الگوریتم را برای تکرارهای مختلف اجرا می کنیم، مانند دوره های ۱۰، ۲۰ و ۴۰٫ جدول ۶ نتایج ارزیابی GA بر روی مدل های FL را نشان می دهد. در اینجا، ما یک نوسان بین ۱ تا ۲۰ تکرار را مشاهده می کنیم. پس از آن، در ۲۰ و ۴۰ نسل بعدی به دقت ۹۱٫۲۸ درصد همگرا می شود. با هایپرپارامترهای تنظیم شده به [۰٫۰۱, ۷]. برای نسل های ۲۰ و ۴۰ بعدی، ما دقت مشابهی را با فراپارامترها دریافت کردیم [۰٫۰۱, ۷]. برای این آزمایش، اندازه جمعیت ۲۰ و نرخ جهش ۰٫۱ را در نظر گرفتیم. شکل ۵ روند دقت و از دست دادن GA را هنگامی که آن را برای ۴۰ تکرار اجرا می کنیم نشان می دهد.

۴٫۵٫ نتایج الگوریتم بهینه سازی ازدحام ذرات

در این رویکرد، مدل ResNet-50 را بر روی الگوریتم PSO اجرا می کنیم، همانطور که در بخش ۳٫۴ بحث شد. ما الگوریتم را برای تکرارهای مختلف اجرا می کنیم، مانند ۱۰، ۲۰، و ۴۰٫ جدول ۷ نتایج ارزیابی PSO را بر روی مدل های FL نشان می دهد. در اینجا مشاهده کردیم که در ۱۰ تکرار با دقت ۹۲٫۶۳ درصد به بهینه محلی دست یافتیم. و بهینه جهانی در ۲۰ نسل با دقت ۹۴٫۹۶ درصد. پس از اجرای مدل برای نسل های ۲۰ و ۴۰ بعدی، دقت مشابهی را با هایپرپارامتر به دست آوردیم. [۰٫۰۱, ۵]. ما پارامترهای زیر را برای الگوریتم PSO در نظر گرفتیم: اندازه ازدحام ۲۰، وزن اینرسی ۰٫۹، وزن شناختی ۲٫۰، و وزن اجتماعی ۲٫۰ است. شکل ۶ روند دقت و از دست دادن PSO را هنگامی که آن را برای ۴۰ تکرار اجرا می کنیم نشان می دهد.

۴٫۶٫ نتایج برای الگوریتم PSOGA الهام گرفته از زیست ترکیبی

ما مدل ResNet-50 را با استفاده از الگوریتم ترکیبی PSOGA، همانطور که در بخش ۳٫۶ بحث شد، اجرا می کنیم. ما الگوریتم را برای تکرارهای مختلف اجرا می کنیم، مانند ۱۰، ۲۰، و ۴۰٫ جدول ۸ نتایج ارزیابی PSOGA را بر روی مدل های FL نشان می دهد. مشاهده می کنیم که آزمایش بهینه محلی را در ۱۰ تکرار با دقت ۹۳٫۶۳٪ ایجاد می کند و یک بهینه جهانی در ۲۰ نسل با دقت ۹۵٫۹۷٪ ایجاد می شود. ما برای ۲۰ و ۴۰ نسل بعدی با هایپرپارامتر به همین دقت رسیدیم [۰٫۰۱, ۷]. ما پارامترهای زیر را برای روش PSOGA در نظر گرفتیم: اندازه ازدحام ۲۰، وزن اینرسی ۰٫۹، وزن شناختی ۲٫۰، وزن اجتماعی ۲٫۰ و نرخ جهش ۰٫۱٫

شکل ۷ روند دقت و از دست دادن PSOGA را هنگامی که آن را برای ۴۰ تکرار اجرا می کنیم نشان می دهد.

۴٫۷٫ نتایج الگوریتم PSOEGA با الهام از زیست ترکیبی

در این رویکرد، مدل ResNet-50 را با استفاده از الگوریتم ترکیبی PSOEGA، همانطور که در بخش ۳٫۷ بحث شد، اجرا میکنیم. ما الگوریتم را برای تکرارهای مختلف اجرا می کنیم، مانند ۱۰، ۲۰، و ۴۰٫ جدول ۹ نتایج ارزیابی GA را بر روی مدل های FL نشان می دهد. در اینجا مشاهده می کنیم که بهینه محلی را در ۱۰ تکرار با دقت ۹۴٫۳۰ درصد و بهینه جهانی را در ۲۰ نسل با دقت ۹۴٫۹۷ درصد به دست می آوریم. پس از اجرای آن برای ۲۰ تا ۴۰ نسل بعدی، با استفاده از فراپارامترها به همان دقت رسیدیم. [۰٫۰۱, ۵]. ما پارامترهای زیر را برای الگوریتم PSOEGA در نظر گرفتیم: اندازه ازدحام ۲۰، وزن اینرسی ۰٫۹، وزن شناختی ۲٫۰، وزن اجتماعی ۲٫۰ و نرخ جهش ۰٫۱ است.

شکل ۸ روند دقت و از دست دادن PSOEGA را هنگامی که آن را برای ۴۰ تکرار اجرا می کنیم نشان می دهد.

جدول ۱۰ مقایسه رویکرد پیشنهادی ما برای PSOGA را نشان میدهد و PSOEGA با تکنیکهای بهینه زیستی فردی به عنوان خط پایه در نظر گرفته میشود. در جدول ۱۰ مشاهده می شود که مدل غیر متمرکز نسبت به مدل متمرکز از دقت کمتری برخوردار است. این به این دلیل است که مجموعه داده در بین کلاینت های مختلف توزیع می شود و در نتیجه سربار ارتباط بین کلاینت ها و مدل سرور ایجاد می شود. در نتیجه، این سربار منجر به کاهش ۳٫۶۹٪ در دقت شد. پس از انجام تنظیم هایپرپارامتر مدل ResNet50 در FL، مشاهده کردیم که از الگوریتم های ترکیبی پیشنهادی ما (PSOGA و PSOEGA)، PSOGA دقت کمی بالاتر از PSOEGA می دهد. ما ۳ درصد برتر را در نظر گرفتیم که ظرفیت اکتشاف ما را محدود می کند و در نتیجه دقت نسبتاً کمتری برای PSOEGA نسبت به PSOGA دارد.

بر اساس نتایج تجربی، نتیجه میگیریم که مدل DL غیرمتمرکز پیشنهادی با PSOGA با دقت ۹۵٫۹۷ درصد از مدلهای دیگر بهتر عمل میکند. این الگوریتم بهتر از DL با مدل های GA و DL متمرکز است، که نتایج قابل احترامی نیز به دست آوردند اما در دقت و دقت کمی عقب بودند. DL پیشنهادی با PSOEGA به طور مشابه عملکرد چشمگیری را نشان میدهد که با دقت ۹۴٫۹۷% با مدل متمرکز DL مطابقت دارد. برخلاف مدلهای مرسوم توسعه یافته توسط پوتلوری و همکاران. [۵۴]ورما و همکاران [۵۵]و خیرالدین و همکاران [۵۶]، که دقت قابل توجهی پایین تر و داده های متریک ناقص را نشان می دهند، رویکردهای پیشنهادی به طور موثر و قوی دقت بالا و عملکرد متریک جامع را متعادل می کنند. ترکیب DL با روشهای بهینهسازی مانند الگوریتمهای ازدحام ژنتیک و ذرات بهطور مؤثری ذخیرهسازی و بارگذاری سرور را مدیریت میکند و در عین حال قابلیتهای تشخیص را به طور قابلتوجهی بهبود میبخشد.

روش پیشنهادی برای تنظیم فراپارامترها در یک مدل DL با استفاده از PSOGA هیبریدی و PSOEGA در FL عملکرد برتر را نشان میدهد. در حالی که تکنیک غیرمتمرکز به دلیل سربار ارتباط اغلب کارآمدی کمتری نسبت به رویکرد متمرکز دارد، روش ترکیبی PSOGA ما از نظر دقت از PSOEGA پیشی میگیرد. عملکرد بهبود یافته را می توان به قابلیت های اکتشافی استثنایی PSOGA ترکیبی نسبت داد که به طور تصادفی والدین را از نیمی از جمعیت انتخاب می کند. این امکان انجام عملیات های متقاطع و جهش های مختلف را فراهم می کند. از سوی دیگر، PSOEGA ترکیبی، که والدین را بر اساس بالاترین سه ارزش تناسب اندام انتخاب می کند، روند کاوش را محدود می کند و در نتیجه سطوح پایین تری از دقت را تولید می کند. اگرچه PSOEGA همگرایی سریعتری را نشان میدهد زیرا از والدین نخبه برای تولید افراد جدید استفاده میکند، کاوش محدود آن در مقایسه با PSOGA منجر به عملکرد ضعیفتر میشود.

۵٫ نتیجه گیری ها

ما یک روش جدید برای تنظیم فراپارامترهای یک مدل DL با استفاده از ترکیبی PSOGA و PSOEGA در FL پیشنهاد کردیم. در مقایسه با سایر روشها، DL پیشنهادی با روش PSOGA بهترین میزان دقت ۹۵٫۹۷ درصد را به دست میآورد که آن را به موثرترین الگوریتمهای پیشنهادی تبدیل میکند. علاوه بر این، امتیاز F1، فراخوانی و دقت نیز به ترتیب با ۰٫۹۲، ۰٫۹۱ و ۰٫۹۳ رقابتی هستند. در حالی که DL با GA 95.64٪ است، به اندازه مدل متمرکز DL دقیق است، با امتیاز F1 0.93. مطالعه ما نشان میدهد که نتیجه رویکرد غیرمتمرکز کمتر از رویکرد متمرکز به دلیل سربار دورهای ارتباطی است. ما دو رویکرد ترکیبی، PSOGA و PSOEGA را پیشنهاد کردیم، که در آن PSOGA ترکیبی دقت بالاتری نسبت به PSOEGA داد. PSOGA ترکیبی دارای اکتشاف بالایی است، زیرا ما به طور تصادفی والدین را از نیمی از جمعیت انتخاب کردیم و عملیات متقاطع و جهش را انجام دادیم. در همین حال، در PSOEGA ترکیبی، ما والدین را از سه ارزش تناسب اندام برتر انتخاب کردیم، که ظرفیت کاوش ما را محدود میکند و منجر به دقت نسبتاً کمتری نسبت به PSOGA میشود. در PSOEGA ترکیبی، با استفاده از والدین نخبه برای ایجاد افراد جدید برای تکرارهای آینده، همگرایی سریعتری را مشاهده کردیم. این مدل های پیشنهادی دارای محدودیت هایی هستند. علاوه بر این، فرآیند بهینهسازی ممکن است نیاز به اجرای چندین بار مدل ResNet50 داشته باشد که منجر به هزینههای محاسباتی بالا برای مجموعه دادههای بزرگ میشود و این امر آزمایش موارد بسیار پیچیده را دشوار میکند.

روشهای بهینهسازی الهامگرفته از زیستی برای رسیدگی به سناریوهای پیچیدهتر و بهبود عملکرد مدل استفاده خواهد شد. چارچوب های دیگری را می توان برای کاهش سربار دورهای ارتباطی بین گره های توزیع شده بررسی کرد. پیشرفتهای آینده در فراپارامترهای تنظیم دقیق میتواند ادغام سایر تکنیکهای فراابتکاری یا بهینهسازی را برای توسعه رویکردهای ترکیبی الهام گرفته از زیستی در نظر بگیرد. این رویکردهای ترکیبی الهام گرفته از زیستی میتوانند از نقاط قوت الگوریتمهای متعدد استفاده کرده و بهینهسازی هایپرپارامتر مؤثرتر و کارآمدتری را ارائه دهند.

منبع: https://www.mdpi.com/2673-2688/5/3/51