در زیر بخش های زیر، innerATT عمدتاً در دو جهت با پیچیدگی های مختلف کار تجزیه و تحلیل می شود: در بخش ۴٫۱، توانایی انطباق با انواع کار مورد بحث قرار می گیرد. رابطه بین رفتار ربات و وزن توجه درونی آنها نیز تجزیه و تحلیل میشود تا ثابت شود که مکانیسم توجه درونی برای تیم کردن انعطافپذیر رباتها در انجام وظایف مختلف مفید است. در بخش ۴٫۲، استحکام HMRS ارائه شده است، به ویژه هنگامی که ربات های نادرست در تیم وجود داشته باشد. innerATTکارایی در مصرف منابع (حرکت مراحل مورد نیاز) برای نجات یک قربانی نیز مورد تجزیه و تحلیل قرار گرفت. در برنامه HMRS دنیای واقعی، توجه نه تنها به استراتژی همکاری که میتواند وظایف پیچیده را به نحو احسن انجام دهد، بلکه به سایر عوامل دنیای واقعی مانند مصرف منابع، هزینه مسافت و غیره نیز اهمیت دارد. از آنجایی که روباتها معمولاً دارای محدودیتهایی هستند. انرژی، اگر منابع انرژی برخی ربات ها خیلی سریع مصرف شود، انرژی کافی برای کارهای آینده باقی نخواهد ماند.

۴٫۱٫ تطبیق با انواع وظایف

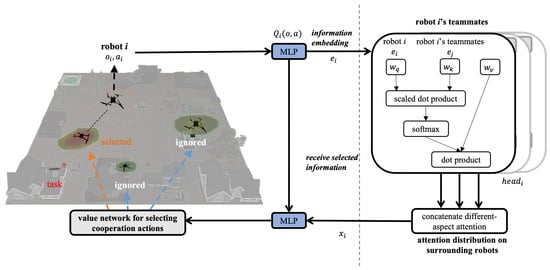

برای تجزیه و تحلیل innerATTتوانایی انطباق با انواع کارها، محیط شبیه سازی شده “تنوع وظایف” شامل دو نوع مختلف کار است: در کار ۱، قربانیان به شدت آسیب دیده اند و به درمان های پزشکی نیاز دارند، در حالی که در کار ۲، قربانیانی که از سلامت خوبی برخوردار هستند به اطلاعات مفید نیاز دارند. آنها را به مکان امن تری راهنمایی می کند. این بدان معناست که ربات های تحویل غذا باید یاد بگیرند که به صورت پویا با ربات های مناسب همکاری کنند و بر اساس موقعیت هایی که به صورت پویا در حال تغییر هستند در وظایف مختلف شرکت کنند. به عنوان مثال، برای نجات قربانیانی که به شدت مجروح شدهاند، ربات ارائه دهنده خدمات پزشکی باید با نزدیکترین و در دسترسترین ربات تحویلدهنده غذا همکاری کند، نه با ربات تحویلدهنده غذا که در فاصلهای دور از آن یا درگیر کارهای نجات دیگر است.

برای اندازهگیری کمی انعطافپذیری روباتها، میزان همکاری بین رباتهای تحویلدهنده غذا و سایر رباتهای نجات در یک دوره زمانی (۸۰ قسمت) با استفاده از فرمول زیر محاسبه میشود:

جایی که تعداد کل قربانیانی است که توسط روبات ها نجات یافته اند من و تعداد کل قربانیانی است که با همکاری روبات ها نجات یافته اند من و ربات جی. نتایج در جدول ۲، در سه موقعیت نشان داده شده است. میانگین نرخ همکاری ربات های تحویل غذا توسط TD-innerATT و PPO innerATTدر کار ۱ به ترتیب ۰٫۴۷/۰٫۵۳ و ۰٫۴۸/۰٫۵۲ هستند که مشابه توزیع یکنواخت با اطمینان ۹۵ درصد است. نرخ همکاری ربات های تحویل غذا توسط TD و PPO روش ها به ترتیب ۰٫۸۲/۰٫۱۸ و ۰٫۳۲/۰٫۶۸ هستند که شواهد کافی برای اثبات مشابه بودن آن با توزیع یکنواخت نیست. نتایج مشابهی برای کار ۲ نشان داده شد: روباتهایی که توسط TD-innerATT یا PPO innerATT نسبت به روشهایی که بدون مدل توجه آموزش دیدهاند، انعطافپذیرتر هستند. همانطور که گمان می رود، منتقدان مدل پایه از همه اطلاعات به صورت غیر انتخابی استفاده می کنند، در حالی که innerATT می توانند از طریق مکانیسم توجه درونی یاد بگیرند که به کدام ربات ها بیشتر توجه کنند. بنابراین، روش با innerATT نسبت به وظایف در حال تغییر پویا انعطاف پذیرتر و حساس تر است.

برای اثبات بیشتر اینکه روش تیمسازی چند رباتی با پشتیبانی درونی برای سازگاری انعطافپذیر ربات با وظایف مختلف مفید است، شکل ۵ با نشان دادن آنتروپی وزنههای توجه، تأثیر سر توجه را بر روی ربات در طول فرآیند آموزش نشان میدهد. هر ربات کاهش آنتروپی به حدود ۱٫۰۲ نشان می دهد که innerATT مکانیزم به طور موثری ربات ها را آموزش می دهد تا به طور انتخابی روی اعضای تیم خاصی تمرکز کنند. این کاهش نه تنها به معنی تمرکز توجه است، بلکه توانایی تکامل یافته ربات ها برای اولویت بندی تعاملات مرتبط با کار، افزایش کارایی مشارکتی آنها در محیط های پویا است. نکته مهم این است که کاهش آنتروپی نشان دهنده بهبود توجه انتخابی در بین ربات ها است که برای سازگاری پویا با الزامات کار و در دسترس بودن ربات بسیار مهم است. متریک آنتروپی به عنوان معیاری نسبی از توانایی سیستم در فیلتر کردن و تمرکز بر اطلاعات مربوطه استفاده میشود که برای کار گروهی موثر بسیار مهم است. به این ترتیب، سطح “خوب” آنتروپی به طور متناوب توسط عملکرد و سازگاری کار بهبود یافته سیستم تعریف می شود، و نقش مکانیسم توجه درونی را در پرورش رفتار مشارکتی کارآمد و متمرکز تایید می کند.

علاوه بر این، رابطه بین رفتار ربات و وزن توجه درونی رباتها برای نشان دادن حمایت توجه در تنظیم رفتارهای ربات برای تیمسازی انعطافپذیر تحلیل شد. شکل ۶A تصویری از یک سناریوی خاص است که در طول آزمایش رخ می دهد. در مرحله پیش، ربات تحویل غذا ۱ ابتدا با ربات کمک پزشکی برای نجات قربانی به شدت آسیب دیده همکاری می کند (وظیفه ۱). در این لحظه، ربات تحویل غذا ۱ باید توجه بیشتری به ربات کمک پزشکی داشته باشد. پس از اتمام کار ۱، در مرحله میانی و پس از مرحله، تغییر می کند تا با یک ربات راهنمای ایمنی همکاری کند تا قربانی گرفتار را در سلامت کامل نجات دهد (وظیفه ۲). در این زمان، ربات تحویل غذا ۱ باید توجه بیشتری به ربات راهنمای ایمنی داشته باشد. شکل ۶B منحنی های وزن کل توجه ربات تحویل غذا را نسبت به سه روبات دیگر نشان می دهد. در مرحله پیش، منحنی کل وزن های توجه پرداخت شده به ربات کمک پزشکی دارای بالاترین مقادیر است که از ربات تحویل غذا ۱ برای همکاری انتخابی با ربات کمک پزشکی پشتیبانی می کند. در مرحله میانی و در مرحله پس از آن، منحنی های وزن کل توجه پرداختی به ربات کمک پزشکی و ربات راهنمای ایمنی به طور جداگانه در حال کاهش و افزایش است که از ربات تحویل غذا ۱ پشتیبانی می کند تا توجه خود را از ربات کمک پزشکی به ربات کمک پزشکی منتقل کند. ربات راهنمای ایمنی بنابراین، innerATT می تواند از رفتارهای تیمی انعطاف پذیر ربات برای کارهای مختلف پشتیبانی کند. شکل ۶C منحنی وزن توجه ربات تحویل غذا ۱ را نشان می دهد که توسط هر سر توجه نسبت به سایر ربات های نجات ایجاد می شود.

علاوه بر این، برای ارزیابی معقول بودن یا نبودن همکاری ربات، «همکاری ناشیانه» و «همکاری تطبیقی مورد انتظار» بر اساس قوانین همکاری فوقالذکر معرفی شدند. در شکل ۷، این موارد معمولی در همه موقعیت ها مشترک هستند. موارد معمولی با توجه به فاصله بین ربات ها و وظیفه به سه دسته تقسیم شدند: هر دو ربات تحویل غذا به قربانی نزدیکتر هستند که به ربات همکار نزدیکتر است، هر دو ربات تحویل غذا به قربانی نزدیکتر هستند که از ربات همکار دورتر است. و یکی از ربات های تحویل غذا به یک قربانی نزدیک تر است، دیگری به قربانی دیگر نزدیک تر است. برای همه موارد، همکاری ناخوشایند (قربانیان توسط نزدیکترین ربات تحویل غذا نجات نمییابند) با خطوط پیکان نارنجی نشان داده میشود، در حالی که همکاری تطبیقی مورد انتظار (قربانیان توسط نزدیکترین ربات تحویل غذا نجات مییابند) با خطوط پیکان سبز ارائه میشود. در موارد همکاری ناخوشایند، زمان بیشتری برای نجات قربانیان توسط ربات ها مورد نیاز است که غیرقابل قبول است، به خصوص در جستجو و نجات بلایا. بنابراین، حتی اگر همکاری نامناسب میتواند قربانیان را نجات دهد، کیفیت همکاری پایینتری نسبت به همکاری تطبیقی مورد انتظار دارد.

برای اندازهگیری کمی کیفیت همکاری ربات، میزان همکاری نامناسب و همکاری تطبیقی مورد انتظار محاسبه شد. همانطور که در جدول ۳ برای روش نشان داده شده است TD-innerATT و PPO innerATT، پس از ۲۰ قسمت، میانگین نرخ همکاری ناخوشایند ربات تحویل غذا ۱ در کار ۱ و وظیفه ۲ به ترتیب ۰٫۱۷، ۰٫۲۲ و ۰٫۲۶، ۰٫۳۰ است. میانگین نرخ همکاری ناخوشایند ربات تحویل غذا ۲ در Task 1 و Task 2 به ترتیب ۰٫۱۷، ۰٫۱۶ و ۰٫۳۰، ۰٫۱۸ است. در مورد نتایج برای روش ها TD و PPO، میانگین نرخ همکاری ناخوشایند ربات تحویل غذا ۱ در Task 1 و Task 2 0.43، ۰٫۴۵، و ۰٫۴۴، ۰٫۴۷ است. میانگین نرخ همکاری ناخوشایند ربات تحویل غذا ۲ در کار ۱ و وظیفه ۲ به ترتیب ۰٫۴۰، ۰٫۴۹، و ۰٫۴۶، ۰٫۴۴ است. نتایج نشان می دهد که روش های با innerATT نسبت به روش پایه، اقدامات مشارکتی ناخوشایند کمتری در وظایف مختلف دارند، زیرا رباتها با مکانیسم توجه درونی میتوانند بهجای همکاری همیشه با یک ربات، با رباتهای مختلف بر اساس موقعیتهای فعلی بهطور انعطافپذیر همکاری کنند. بنابراین، روش هایی با innerATT می تواند اقدامات مشارکتی معنادارتری بر اساس محیط های در حال تغییر پویا در مقایسه با روش پایه داشته باشد.

برای اثبات کمی آن

innerATT در مصرف انرژی بسیار کارآمدتر از روش پایه است، میانگین فاصله مسیر مورد نیاز برای نجات یک قربانی با فرمول زیر محاسبه شد:

جایی که میانگین هزینه مسافت برای نجات یک قربانی در طول زمان T است، کل مسافتی است که با جمع کردن طول مسیر تمام ربات ها در یک دوره زمانی محاسبه می شود تیو تعداد کل قربانیان نجات یافته در طول زمان T است. همانطور که شکل ۸ نشان می دهد، پس از ۱۰۰۰۰ قسمت آموزشی، میانگین هزینه مسافت مسیر مدل آموزش داده شده توسط TD-innerATT 0.14 بیشتر از مدل آموزش داده شده با روش پایه است. مدل آموزش دیده توسط TD کارآمدتر است زیرا مکانیسم توجه درونی پیچیدگی چارچوب شبکه عصبی عمیق را افزایش می دهد. بنابراین، روش پایه می تواند سریعتر از روش با یاد بگیرد innerATT و می تواند قربانیان بیشتری را در ابتدای مرحله آموزش نجات دهد. بعد از ۲۵۰۰۰ قسمت تمرین، وقتی innerATT به اندازه کافی آموزش دیده است، میانگین هزینه مسافت مسیر مدل آموزش داده شده توسط TD-innerATT 0.10 کمتر از مدل آموزش داده شده با روش پایه است. نتایج مشابهی نیز از آزمایشی به دست آمد که در آن مدل ها بر اساس روش PPO آموزش داده شدند. پس از ۲۵۰۰۰ قسمت آموزش، میانگین هزینه مسافت مسیر مدل آموزش داده شده توسط PPO innerATT 0.19 کمتر از مدل آموزش داده شده با روش پایه بود. بنابراین، رباتها با روشهایی با innerATT کارآمدتر از ربات هایی هستند که با روش پایه آموزش دیده اند.

۴٫۲٫ سازگاری با در دسترس بودن ربات

علاوه بر تیم ربات انعطاف پذیر، استحکام در برابر اختلالات دنیای واقعی در HMRS مهم است. اگر رباتها نتوانند بهطور انعطافپذیری با اختلالات دنیای واقعی سازگار شوند، برای مثال، اگر برخی از رباتها در تیم ربات خراب شوند یا اگر خطاها ناشی از خرابی سنسور باشد، ممکن است اثرات نامطلوب و غیرقابل کنترلی روی سایر هم تیمیها ایجاد شود. علاوه بر این، ربات های شکسته ممکن است اطلاعات نادرستی را با سایر اعضای تیم به اشتراک بگذارند که منجر به رفتارهای نادرست همکاری شود.

با innerATT، تیم HMRS در برابر خرابی سنسور یا شکستگی واحدها قوی تر است که از نظر تئوری در بخش روش ها ثابت شده است. برای اندازه گیری عملی استحکام HMRS، مشکل معمولی خرابی ربات “شکستگی موتور” شبیه سازی شده است. سپس، نرخ همکاری رباتهای تحویلدهنده غذا برای برآورد استحکام آنها در برابر اختلال «موتور شکسته» محاسبه میشود. در موارد ایده آل، اگر ربات های تحویل غذا به اندازه کافی قوی باشند، شانس برابری برای مشارکت در استفاده مجدد از وظایف دارند. این بدان معناست که ربات های تحویل غذا تحت تأثیر روبات های معیوب نیستند. همانطور که جدول ۴ نشان می دهد، با در نظر گرفتن وظیفه ۱ زمانی که ربات راهنمای ایمنی خراب است، میانگین نرخ همکاری ربات های تحویل غذا آموزش دیده توسط TD-innerATT و PPO innerATT به ترتیب ۰٫۵۱/۰٫۴۹ و ۰٫۵۱/۰٫۴۹ هستند که مشابه توزیع یکنواخت با اطمینان ۹۵% است. نرخ همکاری ربات های تحویل غذا آموزش دیده توسط TD و PPO روشها ۰٫۸۲/۰٫۱۸ و ۰٫۳۴/۰٫۶۶ هستند، که به این معنی است که رباتهای تحویل غذا به طور قابل توجهی تحت تأثیر ربات شکسته هستند. در مورد وظیفه ۲ هنگامی که ربات کمک پزشکی خراب است، نتایج مشابهی مشاهده می شود. بنابراین، ربات ها با روش هایی با innerATT نسبت به آنهایی که با روش پایه آموزش داده شده اند نسبت به شکست روبات قوی تر هستند.

برای اثبات بیشتر آن innerATT برای استحکام ربات در برابر عوامل دنیای واقعی مفید است، رابطه بین رفتار ربات و وزن توجه درونی آنها برای نشان دادن حمایت های توجه در تنظیم رفتار ربات برای افزایش انعطاف پذیری ربات مورد تجزیه و تحلیل قرار گرفت. شکل ۹A تصویری از یک سناریوی خاص است که در طول آزمایشات رخ می دهد. در مرحله پیش، ربات تحویل غذا ۱ در ابتدا با ربات کمک پزشکی برای نجات قربانی به شدت آسیب دیده همکاری می کند (وظیفه ۱). در این لحظه، ربات کمک پزشکی باید به ربات تحویل غذا ۱ توجه بیشتری داشته باشد. پس از اتمام کار ۱، در مرحله میانی و پس از مرحله، ربات تحویل دهنده DFod 2 با ربات کمک پزشکی برای نجات یکی دیگر از قربانیان به شدت مجروح (وظیفه ۱) همکاری می کند. در این زمان، ربات کمک پزشکی باید توجه بیشتری به ربات تحویل غذا ۲ داشته باشد. شکل ۹B منحنی های وزن کل توجه ربات کمک پزشکی را نسبت به سه ربات دیگر نشان می دهد. در مرحله پیش، منحنی کل وزن های توجه پرداخت شده به ربات تحویل غذا ۱ دارای بالاترین مقادیر است که از ربات کمک پزشکی برای همکاری انتخابی با ربات تحویل غذا ۱ پشتیبانی می کند. در مرحله میانی و در مرحله پس از آن، منحنی وزنهای توجه کل به ربات تحویل غذا ۱ و ربات تحویل غذا ۲ به طور جداگانه کاهش و افزایش مییابد که از ربات کمک پزشکی پشتیبانی میکند تا توجه خود را از ربات تحویل غذا ۱ به ربات تحویل دهد. ۲ ربات تحویل غذا. بنابراین، مکانیسم توجه درونی میتواند با تنظیم رفتار ربات برای افزایش انعطافپذیری ربات، استحکام ربات را نسبت به شکستهای ربات در دنیای واقعی افزایش دهد. شکل ۹ C منحنی وزن توجه ربات کمک پزشکی را نشان می دهد که توسط هر سر توجه نسبت به سایر ربات های نجات ایجاد می شود.

منبع: https://www.mdpi.com/2673-2688/5/2/29