۲٫۱٫ YOLOv1

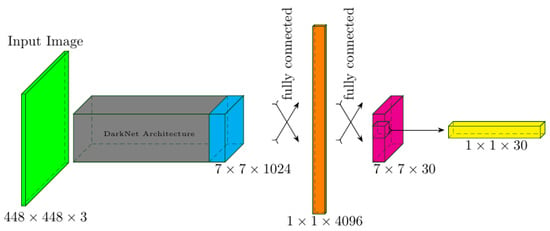

معماری YOLOv1 در شکل ۱ نشان داده شده است و از مدل GoogLeNet الهام گرفته شده است. [۳۴] با ۲۴ لایه کانولوشن که از تصاویر آموزشی ورودی با اندازه نمونه برداری می کند به a تانسور (معماری DarkNet در شکل ۱). یک شبکه از سلولها ایجاد شدند که هر سه کانال تصویر ورودی را شامل میشوند. YOLOv1، در هر سلول شبکه، دو جعبه محدود و احتمالات کلاس مربوط به آنها را پیش بینی می کند. را تانسور به صورت مسطح شده است وکتور برای لایه ورودی کاملا متصل پس از پردازش از طریق یک لایه پنهان کاملاً متصل، لایه خروجی کاملاً متصل یک بردار از ابعاد را برمیگرداند . تا در نهایت برای هر یک از آنها یک پیش بینی به دست آوریم سلول های شبکه، اندازه بردار خروجی کاملا متصل به a تغییر می کند تانسور که به آن تانسور پیش بینی می گویند.

بیایید a را استخراج کنیم بردار پیش بینی لایه آخر، همانطور که در شکل ۱ به رنگ زرد نشان داده شده است، و مشاهده کنید که شامل ۲۰ احتمال کلاس شرطی به همراه دو بردار است که هر کدام به اندازه هستند. . این با ۲۰ کلاس برچسبگذاری شده مطابقت دارد که در چالش کلاسهای شی بصری PASCAL (VOC) ظاهر شدهاند. [۳۵]در حالی که هر یک از پیشبینیکنندهها با دو ویژگی جعبه مرزی یافت شده، یعنی ، ، و به عنوان مرکز، ارتفاع، عرض و امتیاز اطمینان [۳۶]. تقاطع بیش از اتحادیه (IoU) حقیقت زمین و جعبه مرزی پیش بینی شده یک معیار اندازه گیری مهم در مدل YOLO است.

معماری YOLOv1 اجزای تشخیص و طبقه بندی شی را در یک چارچوب یکپارچه ادغام می کند [۱۶]. این ادغام از طریق تابع هزینه مرکب (معادله (۴)) که از سه بخش تشکیل شده است به دست می آید: از دست دادن محلی سازی (معادله ۱))، از دست دادن اعتماد به نفس (معادله (۲))، و از دست دادن طبقه بندی (معادله (۳)). این مولفههای از دست دادن با هم به هدف کلی آموزشی YOLOv1 کمک میکنند و وظایف تشخیص و طبقهبندی شیء را به طور همزمان ممکن میسازند.

اجازه دهید با این شروع کنیم

از دست دادن محلی سازی (معادله (۱))، که مدل را به پیش بینی دقیق مختصات موقعیت و ابعاد ارتفاع و عرض جعبه های مرزی تشویق می کند.

،

،

و

. از آنجایی که تلفات محلیسازی به حداقل میرسد، مدل یاد میگیرد که مختصات پیشبینیشده را برای همسویی با مختصات حقیقت زمین تنظیم کند، که منجر به بهبود دقت محلیسازی میشود. با این کار، از دست دادن محلی سازی به شرح زیر است:

جایی که در صورتی که مقدار ۱ به آن اختصاص داده شود جی-ام جعبه مرزی در منسلول -ام مسئول تشخیص یک شی است و ۰ در غیر این صورت. اینجا تعداد جعبه های محدود پیش بینی شده برای هر سلول است.

از دست دادن اعتماد به نفس (معادله (۲)) برای شی (حقیقت زمینی) و امتیاز اطمینان کلاس (پیش بینی شده) اعمال می شود.

ج و

به ترتیب، و اشیاء پیشبینیشده اشتباه را که با جعبههای مرزی آنها در سراسر سلولهای شبکه تصویر ورودی محصور شدهاند جریمه میکند:

کجا، با دانستن آن یک متغیر نشانگر باینری است، اگر مقدار ۱ باشد جی-ام جعبه مرزی در منسلول -امین شیء شناسایی شده ندارد و در غیر این صورت ۰٫ در این زمینه، ج و هر دو در محدوده هستند . اولی یک اتصال ضربی IoU و احتمال وجود یک شی مرکز در سلول شبکه است. . این اطلاعات از حقیقت پایه می آید و ۱ یا ۰ است. ج یا برابر با IoU یا ۰ است. در طول فرآیند آموزش آموخته می شود، زیرا IoU و احتمالات کلاس را به صورت ضربی ترکیب می کند و . این منجر به یک امتیاز اطمینان ویژه کلاس برای هر سلول شبکه می شود، زیرا احتمال کلاس تنها زمانی مرتبط است که مرکز یک شی در سلول باشد. در مجموع، این امتیاز حاوی اطلاعاتی در مورد میزان خوب بودن پیشبینیهای جعبه کلاس در هر سلول است. حقیقت پایه امتیاز اطمینان مستقیماً توسط یک انسان حاشیه نویسی نمی شود، بلکه به صورت داخلی بر اساس کادر مرزی حقیقت زمین محاسبه می شود.

هدف از ضریب در از دست دادن محلی سازی (معادله (۱)) را می توان در مقایسه با استفاده از به عنوان بخشی از از دست دادن اطمینان در معادله (۲) ظاهر می شود. هر دو ضریب نقش مهمی در کاهش بی ثباتی مدل در طول مرحله آموزش دارند. را از دست دادن مرتبط با اشیاء پیشبینیشده اشتباه در سلولهای شبکه، یعنی مناطق پسزمینه که بهطور اشتباه بهعنوان یک شی پیشبینی شدهاند را جریمه میکند. مقدار کمی از با ادامه آموزش، تعداد موارد نادرست را کاهش می دهد. متقابلا، اهمیت مکان یابی دقیق اشیا و جعبه های مرزی آنها را تشویق می کند. نویسندگان YOLOv1 مقدار نسبتاً کمتری را به آن اختصاص دادند به در رابطه (۲)، در حالی که آنها مقدار بزرگتر ۵ را برای در نظر گرفتند در معادله (۱). این انتخاب به طور موثر مدل YOLOv1 را تشویق میکند تا روی شناسایی جعبههای محدودکنندهای تمرکز کند که بهطور دقیق اشیاء را نشان میدهند و در عین حال تأثیر جعبههای محدودکننده پسزمینهای که به اشتباه پذیرفته شدهاند را کاهش میدهد.

در نهایت، YOLOv1 شامل

از دست دادن طبقه بندی به شرح زیر است:

جایی که نشان دهنده احتمال کلاس حقیقت پایه، یعنی برچسب کلاس، برای کلاس است س در جی-ام جعبه مرزی من– سلول شبکه ای. این یک کد گذاری شده است، به این معنی که برای کلاس هدف ۱ و برای همه کلاس های دیگر ۰ است. عبارت یک متغیر شاخص باینری است که در صورت وجود مقدار ۱ را می گیرد منسلول -امین یک شی است، در غیر این صورت، ۰٫ توجه داشته باشید که توسط مدل در مرحله آموزش تخمین زده می شود. برای این منظور، ضرر کل YOLOv1 استنباط شد [۱۶] مانند

۲٫۲٫ YOLOv3

یک مزیت قابل توجه که YOLOv3 را تعیین می کند [۱۸] جدای از YOLOv1 توانایی آن برای پیشبینی در مقیاسهای چندگانه است. این قابلیت از طریق ادغام Darknet-53 انجام می شود [۱۹]در ابتدا به عنوان یک شبکه ۵۳ لایه آموزش دیده در ImageNet طراحی شد [۳۷]. برای افزایش قابلیت تشخیص، تعداد لایههای شبکه دو برابر شد که منجر به یک معماری ۱۰۶ لایهای کاملاً پیچیده برای YOLOv3 شد. در Darknet انباشته شامل ۱۰۶ لایه، تکنیکهای upsampling و الحاق سه بار به کار گرفته شده و نقشههای ویژگی با ابعاد ، و . همانطور که مستند در [۱۸]تولید این نقشههای ویژگی شامل نمونهبرداری از نقشههای ویژگی مربوطه از دو لایه قبلی با ضریب ۴ است. متعاقباً، این نقشههای نمونهبرداری شده با نقشههای ویژگی قبلی مربوطه خود از شبکه الحاق میشوند. به گفته نویسندگان [۱۸]استفاده از تکنیکی که به عنوان شبکه هرمی ویژگی (FPN) شناخته می شود [۳۸] هدف آن به دست آوردن اطلاعات معنایی قابل توجه از ویژگی های نمونه برداری شده و اطلاعات دقیق تر از نقشه های ویژگی قبلی است. در YOLOv3، هر تانسور خروجی با ابعاد در مجموع شامل جعبه های مرزبندی این جعبه ها با شش ویژگی مشخص می شوند: مختصات مرکز، ابعاد، امتیاز شیئی و مجموعه ای از ۸۰ [۳۹] اطمینان طبقاتی مشروط با پیشبینی YOLOv3 در سه مقیاس مجزا، در مجموع نه جعبه محدودکننده «مشتقشده» پیشبینی میشود. این اشتقاقها با استفاده از مجموعهای از جعبههای لنگر از پیش تعریفشده اجرا میشوند، که در ابتدا در مرحله پیشپردازش به YOLOv3 عرضه میشوند و به عنوان «خوشههای ابعاد» شناخته میشوند. [۱۷].

هدف اصلی جعبه های لنگر ایجاد مجموعه ای محدود از اشکال از پیش تعریف شده است که از مجموعه داده ها و جعبه های حقیقت زمینی موجود مشتق شده اند. این امکان را برای مقایسه در طول مرحله آموزش فراهم میکند، جایی که جعبههای حقیقت زمین با این لنگرها تطبیق داده میشوند و مدل تحولات بین لنگرهای از پیش تعریفشده و جعبههای حقیقت واقعی زمین را یاد میگیرد. در این زمینه، مدل با انتخاب جعبه لنگر با بالاترین IoU با جعبه حقیقت زمین آموزش داده می شود. در استفاده از رویکرد خوشه بندی K-means [40]، در مجموع نه جعبه لنگر تعیین می شود که هر یک نشان دهنده جعبه لنگر متوسط در یکی از نه خوشه ایجاد شده در مقیاس های مختلف است. این خوشه بندی با ارجاع به مجموعه داده COCO انجام می شود [۳۹]. مزیت اصلی این جعبههای قبلی در توانایی آنها در افزایش ظرفیت YOLOv3 برای پیشبینی اشیاء متعدد است که نسبتهای مختلف ارتفاع و عرض در مقیاسهای مختلف را در خود جای میدهند.

منبع: https://www.mdpi.com/2673-2688/5/2/30